SOMMAIRE

– Porte ouverte sur un monde invisible

– Deux révolutions quantiques

– Intrication et décohérence, une franche opposition

– Cryptographie et Cie

– Expérimentation(s)

– Premiers développements de l’ordinateur quantique

– Jeunes chercheurs en entreprise

De Interstellar à Oppenheimer en passant par Avengers : Endgame, la fiction fait la part belle aux lois et étrangetés quantiques. Mais si elle ne fait étalage de ses mystères en public que depuis quelques années, la théorie quantique fête son centenaire, et plus encore. Depuis ses premières formulations au tout début du XXe siècle, les plus éminents scientifiques l’étudient, parviennent à fournir les preuves de sa réalité, et donnent matière à considérer le monde qui nous entoure sous un nouveau jour.

Aujourd’hui les États développent des programmes ambitieux, les grandes entreprises multiplient les investissements, les start-up fleurissent : chacun à son niveau se prépare aux bouleversements prodigieux que laissent envisager les développements de la science et des technologies quantiques, et à leurs potentiels impacts sur la société.

Au siècle dernier, la première révolution quantique était celle de la compréhension de la matière et de ses propriétés, à l’origine d’avancées scientifiques qui ont profondément modifié notre quotidien ; la seconde est en cours, elle repose sur l’exploitation des ressources quantiques pour la mise au point des technologies de demain.

Théorie plus que centenaire et science du futur : le quantique ne craint pas d’être jugé paradoxal.

D’une conception du monde traduite en équations par les mathématiciens, décortiquée et mise en évidence par les physiciens, avant d’être la source d’extraordinaires développements technologiques, le quantique poursuit son inexorable progression. Une longue aventure ponctuée d’intenses débats philosophiques et questionnements scientifiques, tant ce nouveau paradigme a modifié les façons de penser, de considérer les phénomènes à l’œuvre dans la nature, et d’envisager des possibilités jusqu’alors inconnues.

Ce qu’il est convenu aujourd’hui d’appeler la physique classique s’applique au monde macroscopique, celui qui familièrement nous entoure. La physique quantique, elle, prend le relais pour comprendre, décrire et tirer des bénéfices de ce qui se passe à très petite échelle, à la taille de l’atome et moins encore. Les lois qui régissent l’un et l’autre de ces deux mondes sont radicalement différentes, cela demande d’emblée un effort d’imagination.

Là où la physique classique parle mesures objectives et certitudes, comme en mécanique ou en thermodynamique, la physique quantique repose sur des lois de probabilité. On ne peut pas savoir où se trouve par exemple un électron, il n’y a que des probabilités qu’il soit dans un état d’énergie ou un autre. On fait donc comme s’il était dans plusieurs états en même temps, la prise de mesures étant le seul moyen de détruire l’incertitude.

C’est le principe de la superposition quantique, totalement étrangère à notre monde observable, qu’illustre l’histoire du chat de Schrödinger. Le scientifique autrichien a voulu ainsi le rendre plus compréhensible : enfermé dans une boîte avec un dispositif susceptible de le tuer s’il se déclenche, le chat est peut-être mort, peut-être vivant, on ne peut le savoir que si on ouvre la boîte : c’est l’observation qui établit la réalité d’une hypothèse. À noter que le chat n’est pas « à la fois » mort et vivant comme l’indique parfois cette formule, que les scientifiques jugent inadaptée.

À nos yeux qui ne voient que ce qui leur est possible de saisir, les lois et propriétés de la physique quantique semblent contradictoires ou paradoxales ; elles défient l’imagination, parce qu’il est nécessaire de faire abstraction de notre sens commun pour les aborder. Et si elles sont de mieux en mieux comprises et décryptées, elles portent toujours des parts d’ombre qui continuent à nourrir les débats.

La première révolution quantique est ainsi fondée sur un principe qui, en son temps, a paru totalement insolite et ambigu : la dualité onde-particule.

En décembre 1900, Max Planck, « le père de la physique quantique », énonce que l’énergie rayonnante est composée de corps élémentaires, les quanta. Cinq ans plus tard, Einstein met en évidence les quanta d’énergie contenus dans l’onde lumineuse, qui seront nommés photons. En 1923, Louis de Broglie découvre la nature ondulatoire des électrons : la dualité onde-corpuscule est généralisée à toute la matière.

Une métaphore permet de mieux rendre concrète cette dualité : au fond de la mer, on voit le sable former de petites oscillations, il paraît semblable à une onde ; mais si on s’en approche, on distingue les grains qui le constituent. De la même façon que le sable, une onde lumineuse révèle les photons qui la composent et qui transportent l’énergie, dès lors qu’on la regarde de plus près, de très près même. C’est donc l’échelle à laquelle on observe la lumière, pour reprendre cet exemple, qui met en évidence soit ses caractéristiques ondulatoires, soit ses propriétés corpusculaires.

La compréhension des processus régissant le comportement des particules s’est traduite en modèles mathématiques, dont les premiers datent de 1925. Ces outils théoriques ont permis de mettre en évidence les propriétés mécaniques, optiques et électriques de la matière, qui ont donné naissance à des technologies majeures au cours de la seconde moitié du XXe siècle : le laser, impliqué dans une foule d’applications, de la télécommunication par fibres optiques à l’usinage des matériaux ; le transistor, à la base du développement des circuits électroniques de nos ordinateurs ou téléphones portables ; la résonance magnétique nucléaire, utilisée dans le domaine médical avec l’imagerie par résonance magnétique (IRM), ou en chimie avec la spectroscopie.

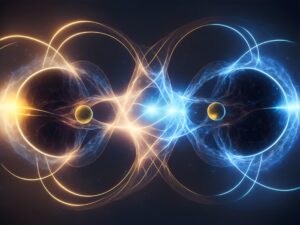

Depuis 1970, on sait isoler un unique atome, l’observer et le conserver. Cette possibilité de manipuler individuellement des particules marque les débuts de la seconde révolution quantique. Révolution qui repose aussi et surtout sur la mise en évidence d’une propriété quantique de premier plan : l’intrication. Lorsqu’elles sont placées dans un état intriqué, deux particules, ou groupes de particules, constituent un système lié dans lequel elles sont dépendantes l’une de l’autre. Leurs propriétés physiques sont corrélées, quelle que soit la distance qui les sépare.

Ce phénomène, qui a donné lieu à un débat théorique jamais clos entre deux monstres sacrés de la physique, Einstein et Bohr, est prouvé par une expérience réalisée en 1982 par le physicien français Alain Aspect. Une longue série d’essais s’ensuit, qui en 2015 ne laisse plus place au moindre doute. L’intrication quantique est dès lors une vérité scientifique. Elle s’explique par une corrélation entre deux particules intriquées pouvant donner lieu à des effets instantanés, donc plus rapides que la vitesse de la lumière, une réalité à laquelle Einstein ne pouvait se résoudre. Alain Aspect obtient le prix Nobel de physique en 2022, récompense ultime pour ses travaux, quarante ans après sa célèbre première expérience.

Si les chercheurs savent créer des états intriqués entre des particules, protéger cette intrication représente toujours un vrai défi.

Les atomes ne sont jamais seuls. Ils interagissent avec un environnement, donnant lieu à la notion de système quantique ouvert. L’environnement dans lequel évoluent les atomes est traversé de champs électromagnétiques, un « bruit ambiant » susceptible de modifier, voire de détruire les propriétés quantiques associées à l’intrication.

Ce phénomène délétère, appelé décohérence, est dans la ligne de mire de spécialistes comme Bruno Bellomo, enseignant-chercheur en physique théorique à l’UMLP / Institut UTINAM, dans le cadre de ses études sur le « contrôle de systèmes quantiques ouverts optimisés ».

« Un objectif majeur de cette recherche est de combiner les avantages de deux méthodes pour protéger les systèmes de la décohérence. La première exploite directement la dynamique dissipative des systèmes quantiques : les bruits environnementaux, dont il est impossible de s’affranchir totalement, sont manipulés et utilisés de telle sorte que l’environnement devienne lui-même une ressource capable d’opérer un contrôle sur les systèmes. La deuxième stratégie consiste à recourir à des champs de contrôle externes que l’on peut faire varier dans le temps, en jouant sur leurs fréquences et sur leur forme. De cette façon, on peut éliminer en partie les effets des bruits environnants. De très bons résultats ont été obtenus avec cette deuxième stratégie, identifiant un protocole de protection d’opérations sur des systèmes quantiques efficace pour plusieurs types de bruits, quelle que soit leur nature exacte », se réjouit le chercheur, qui ajoute : « Les systèmes quantiques ouverts sont au centre des questionnements actuels. Ils représentent un moyen d’étudier la transition entre physique classique et physique quantique, et de comprendre le passage entre ces deux descriptions. »

Le phénomène si fragile de l’intrication passionne aussi le mathématicien Uwe Franz, enseignant-chercheur en analyse fonctionnelle à l’UMLP / LmB, qui s’intéresse plus particulièrement à ce phénomène lorsqu’il concerne plusieurs particules. « Le quantique fournit beaucoup de questions différentes, c’est un sujet de recherche vivant, à la base de nouvelles méthodes, d’idées innovantes, et pour lequel des progrès sont réalisés tous les jours. »

Le chercheur élabore des modèles de transmission d’information pour faire progresser la théorie dite des canaux quantiques. « Dans la réalité, la qualité de transmission des informations quantiques se dégrade au fil du temps. Il s’agit de regarder comment les systèmes évoluent, de voir s’ils convergent vers un « bruit blanc » signifiant qu’à un moment donné, il ne subsiste plus aucune information quantique. »

Il s’agit également de caractériser la nature et la quantité d’informations perdues, et de là de réussir à construire des mécanismes de correction. L’introduction de redondances, qui implique la répétition des informations transmises, pourrait par exemple être un moyen de retrouver des données perdues.

« L’émergence de nouvelles théories est un objectif de la recherche en mathématiques. Ces théories peuvent donner lieu à la formulation de processus qui aujourd’hui intéressent les physiciens, et qui avaient déjà été observés par les mathématiciens dans d’autres contextes. Si elles ne sont pas encore forcément exploitables par la physique, il est certain qu’elles se traduiront plus tard dans des applications. »

L’intrication donne lieu à de nouveaux développements de la cryptographie, qui regroupe des techniques de chiffrage des données dont les plus anciennes sont attestées dès l’Antiquité. À l’époque d’internet, la cryptographie est indispensable au quotidien pour sécuriser les communications, surtout les plus sensibles, concernant par exemple les transactions bancaires ou les informations médicales.

La cryptographie quantique ne concerne pas le codage d’un message lui-même, mais la distribution sécurisée de clés de chiffrement qui permettent à deux interlocuteurs distants, l’un de pouvoir coder le message au départ, l’autre de pouvoir le déchiffrer à l’arrivée. Recourir à des photons intriqués pour le transport de l’information est un moyen optimal d’assurer la sécurité d’une transmission : entre l’émission et la réception du message, d’un photon à l’autre, la moindre tentative d’interception de la transmission est détectable en temps réel, car toute action sur l’un des photons impacte instantanément l’état de l’autre.

Si la cryptographie est actuellement une application phare du domaine quantique, d’autres se profilent : de nombreux termes comme calcul, internet, capteur…, peuvent être associés à l’adjectif quantique.

« Les possibilités sont immenses. Si la première révolution a favorisé le développement technologique, la seconde représente un véritable saut conceptuel, un changement d’échelle considérable », expose Maxime Jacquot, enseignant-chercheur en optique à l’UMLP / Institut FEMTO-ST.

Un bouleversement porteur d’enjeux, auxquels veut se préparer la France avec le Plan quantique, lancé en 2021 et doté de 1,8 milliard d’euros. En Bourgogne – Franche-Comté, les chercheurs en mathématiques, physique théorique, optique et informatique du domaine quantique sont réunis en réseau dans le cadre de ce programme national de structuration des moyens de la recherche, de l’enseignement et de l’industrie.

À l’intérieur du Plan quantique, le projet QuanTEdu-France est dédié à la formation et représente un investissement de l’ordre de 56 millions d’euros, dont 800 000 € sont fléchés pour la Région Bourgogne – Franche-Comté. Maxime Jacquot a assuré le copilotage du projet au niveau régional, il vient de passer le relais à son collègue Mayeul Chipaux, titulaire d’une chaire de professeur junior en optique, sciences et technologies quantiques, pour sa coordination à l’échelle d’UMLP. « QuanTEdu-France prévoit d’assurer la transformation de l’offre de formation afin de l’adapter à la donne quantique. Cela signifie dispenser des formations à l’université dès après le bac jusqu’au doctorat, financer des thèses, préparer des milliers de jeunes à des diplômes d’ingénieur, afin de répondre aux besoins croissants de la recherche et de l’industrie. »

Le projet QuanTEdu donne aussi l’opportunité d’acquérir du matériel de pointe. Un dispositif de travaux pratiques inédit permet ainsi aux étudiants de rentrer pleinement dans le sujet. Il fonctionne depuis la dernière rentrée sous la supervision de Jean-Marc Merolla, chercheur CNRS à l’Institut FEMTO-ST. Des sources à photons jumeaux, des interféromètres, des détecteurs de photons, des détecteurs de bruits donnent une réalité physique, expérimentale, à l’étude du domaine quantique¹. Mis en place cette année pour la première fois pour les étudiants de master 2, ces TP seront ensuite proposés aux doctorants, et pourront être délocalisés hors des murs de l’université comtoise pour en faire bénéficier d’autres étudiants.

De tels équipements sont bien sûr également utiles à la recherche. Jean-Marc Merolla travaille à la mise au point de réseaux quantiques terrestres et spatiaux, pour le transfert d’informations quantiques.

Dans ce cadre, le système cryogénique avec supraconducteurs dont s’est équipé le laboratoire est très performant pour refroidir les systèmes et éviter le bruit provenant de l’agitation thermique. Il permet de générer très efficacement des photons dans les longueurs d’onde de l’infrarouge, qui sont celles des télécommunications. Pour les besoins de ce domaine, les chercheurs peuvent ainsi structurer des composants en silicium ou en niobate de lithium, un cristal photonique particulièrement prisé pour ses qualités.

L’exploitation de différentes longueurs d’onde et fréquences de la lumière est de longue date la spécialité des chercheurs en optique de l’Institut FEMTO-ST. Partant de cette option scientifique, les technologies actuelles et futures pourront se développer de façon complémentaire, en fonction des applications. « Les technologies quantiques permettent d’aller plus loin en distance, et de repérer des signaux plus faibles. Par exemple, les nouvelles générations de LIDAR, une technique de mesure à distance par laser, donneront la possibilité de détecter des polluants dans l’atmosphère ou des variations de température de façon très fine, à des dizaines de kilomètres de distance », explique Jean-Marc Merolla.

C’est aussi par l’expérimentation que pourront émerger, pour les besoins de l’industrie, des solutions techniques faciles à mettre en œuvre, ou tout au moins susceptibles de s’affranchir de certaines contraintes de fabrication. Toujours à FEMTO-ST, une recherche développée par Mayeul Chipaux vise l’utilisation d’objets quantiques qui ne nécessitent pas de mise sous vide et peuvent être réalisés à température ambiante.

Entre physique quantique et nanosciences, cette recherche s’intéresse au diamant et plus encore à un défaut que peut présenter ponctuellement sa structure cristalline, appelé « centre azote-lacune », et que les chercheurs savent reproduire. Il s’agit de remplacer un des atomes de carbone constituant le diamant par un atome d’azote, qui se juxtapose à une place laissée « vacante » par le retrait d’un autre atome de carbone. La création de centres azote-lacune donne localement au diamant des propriétés de luminescence exploitables pour la détection d’infimes champs magnétiques, champs électriques, contraintes mécaniques et processus biologiques. Ces travaux promettent des développements novateurs dans le domaine des capteurs, par exemple pour la cryptographie quantique ou l’imagerie médicale.

Les applications de la physique quantique, en cours ou à venir, qu’elles découlent de la première ou de la seconde révolution quantique, sont regroupées par les spécialistes en quatre grands domaines : la cryptographie et les réseaux, les capteurs et la métrologie, la simulation, l’ordinateur et les systèmes d’information. Dans cette dernière partie, l’ordinateur quantique est aujourd’hui devenu une réalité.

Les premiers processeurs quantiques apparaissent à partir de 2017. Monopolisant d’importantes ressources technologiques et financières, ils sont développés par de grandes entreprises comme IBM ou Google, ou par des start-up. « Pour l’instant, ils ne présentent pas une fiabilité suffisante pour atteindre la « suprématie quantique » promise, mais nous n’en sommes qu’au commencement. À la naissance de l’informatique au début des années 1950, les ordinateurs étaient loin de ce qu’ils sont aujourd’hui ! », compare Frédéric Holweck, enseignant-chercheur en mathématiques à l’UTBM / ICB. L’ordinateur quantique donne d’ores et déjà la possibilité aux théoriciens de tester leurs modèles mathématiques pour expliquer les principes quantiques, et d’obtenir des preuves de concept en un temps record.

« Depuis quelques années, l’ordinateur quantique change la dynamique de la recherche, parce que son fonctionnement est différent, c’est très intéressant d’un point de vue scientifique. Il est aussi utilisé dans l’enseignement, pour lequel il fait entrer un peu d’expérimentation dans la théorie, et rend ainsi les choses moins abstraites. » Si Google et Amazon vendent tout accès à leurs machines, IBM propose une connexion gratuite, limitée à dix minutes par mois. « Cela paraît peu, mais c’est en réalité amplement suffisant pour produire des calculs qui, une fois les tests préparés sur des simulateurs, ne demandent parfois que quelques secondes ! »

L’ordinateur quantique n’est pas qu’un moyen de produire plus vite des résultats. En réalisant des calculs de façon différente, il donne avant tout la possibilité de résoudre des problèmes complexes auxquels ne saurait s’attaquer un ordinateur classique. L’exemple du voyageur de commerce illustre bien cette différence : à partir d’une liste de villes à visiter sur une région, l’ordinateur quantique peut organiser la tournée du commercial de façon optimale, en effectuant moins d’opérations qu’un ordinateur classique, qui procéderait par force brute en essayant toutes les combinaisons. L’ordinateur quantique peut simultanément explorer différentes solutions.

« Ce n’est pas seulement une question de puissance, ce sont d’autres chemins pris », souligne Frédéric Holweck. Sur ces chemins pavés de propriétés quantiques, les qubits, les plus petites unités de stockage d’information quantique, équivalents des bits de l’informatique classique, sont dans un état de superposition qui donne la possibilité d’effectuer des calculs massifs en parallèle, et de réaliser ainsi des opérations inédites. Classique ou quantique, ce sont des systèmes à deux niveaux. Mais là où un algorithme classique élabore des combinaisons à partir des deux porteurs d’information que sont les chiffres 0 et 1, un algorithme quantique travaille sur des valeurs comportant plusieurs possibilités simultanées. N’oublions pas que ce sont les probabilités qui établissent les règles dans le monde quantique…

« Des dispositifs comptant plus de deux niveaux sont même possibles, ils permettent de traiter la même quantité d’informations en utilisant un nombre inférieur de systèmes élémentaires. On parle dans ce cas de qudits », précise Bruno Bellomo à l’Institut UTINAM.

À deux ou à plusieurs niveaux, dans tous les cas les systèmes d’information quantiques reposent sur la superposition d’états et l’intrication de particules de matière, comme les atomes d’aluminium sur lesquels a été créé le premier prototype de processeur quantique, à l’université Yale, en 2009.

L’un des avantages de l’ordinateur quantique est sa faible consommation énergétique, moindre que supposée au départ. Pourtant le zéro absolu, soit environ - 273 °C, est la règle pour un fonctionnement adiabatique de l’ordinateur quantique, c’est-à-dire ne produisant aucun transfert thermique entre un système et son environnement. Une nécessité, car la perte d’énergie fait partie des bruits susceptibles d’introduire de la décohérence dans les systèmes. La réfrigération et le maintien au froid représentent cependant beaucoup moins d’énergie que la consommation d’un ordinateur classique.

Frédéric Holweck travaille à la représentation géométrique de phénomènes tels que la contextualité, qui stipule que, lorsqu’on mesure par exemple la position ou la vitesse d’une particule, cette mesure dépend du contexte dans lequel elle aura été établie. « La mesure est aléatoire, c’est un pur phénomène probabiliste. »

Probabiliste, et déroutant pour nos esprits cartésiens. Cela reviendrait à dire, à l’échelle de notre monde, que le fait de poser des questions à un individu sur ses caractères physiques modifierait ces caractères au fur et à mesure des questions : si on lui demande la couleur de ses yeux, sa taille et son poids, et ensuite la couleur de ses cheveux ou sa pointure, la couleur de ses yeux ne sera plus forcément la même. Une idée dérangeante, alors que la contextualité et l’idée que l’observation influence la chose observée existent cependant bien dans le monde classique. Si un cuisinier ouvre son four pour vérifier la cuisson d’un soufflé au fromage, il fait entrer du froid dans le four, ce qui fait instantanément retomber le soufflé.

La chose observée n’est donc pas la même, avant et après la mesure. Mais en physique quantique, le postulat est plus fort. La mesure et le contexte ne modifient pas la réalité, ils en définissent le sens. Autrement dit, il n’y a pas de réalité physique, au sens classique du terme, avant l’opération de mesure et hors d’un contexte expérimental (ensemble des mesures faites avant ou après).

Du domaine de la physique, le quantique a donc naturellement investi celui de l’informatique, favorisant la création de start-up ou le développement d’activités existantes.

C’est ainsi qu’Hamza Jaffali et Henri de Boutray, après avoir chacun réalisé une thèse en informatique à l’UMLP / Institut FEMTO-ST, ont rejoint l’équipe de ColibriTD. La mission de la start-up parisienne s’oriente dans deux directions : mettre au point des algorithmes pour la résolution de problèmes industriels concrets, et accompagner les entreprises à faire leur entrée dans le monde quantique. Dans ce contexte, les échanges avec le monde académique sont actifs, comme en témoignent les liens se prolongeant entre les jeunes chercheurs et leurs anciens directeurs de thèse, Frédéric Holweck, Alain Giorgetti et Jean-Marc Merolla. La boucle est bouclée. Les investigations peuvent continuer.

La majorité des ordinateurs quantiques accessibles sur le marché se situe aux alentours de 40 qubits, une capacité d’exécution pour laquelle les algorithmes développés chez ColibriTD sont adaptés. Henri de Boutray met les chiffres en contexte : « Avec 6 qubits, il est possible de résoudre des équations différentielles simples, comme celles qui traduisent la déformation mécanique des matériaux ou qui sont utilisées pour établir les prévisions météo. Avec 40 ou 50 qubits, on entre dans le domaine des équations différentielles à plusieurs dimensions, aptes à résoudre des problématiques de recherche ou industrielles. »

Du côté du développement des machines, les ordres de grandeur deviennent vite hallucinants, par exemple chez IBM, dont les ordinateurs affichaient 5 qubits il y a trois ans, entre 100 et 200 qubits aujourd’hui, et annoncent 1 000 qubits pour 2026, des valeurs indiquées avec corrections d’erreurs. « Il y a quelques années, un ordinateur quantique a réussi à factoriser le chiffre 15, c’était une première avec des photons ! C’était la preuve de sa capacité à implémenter l’algorithme quantique de Shor, qui en factorisant de très grands nombres entiers, pourrait défier la sécurité des systèmes de cryptographie actuels. Mais pour que cet algorithme devienne réellement une menace, son implémentation nécessiterait des centaines de milliers de qubits ! » complète Hamza Jaffali.

De leur côté, les deux docteurs en informatique travaillent à la mise au point d’algorithmes quantiques susceptibles de résoudre des problématiques de production industrielle, comme la simulation de crash de véhicules pour BMW, ou la simulation de phénomènes de combustion dans les réacteurs d’avions avec ONERA, le centre français de recherche aérospatiale.

« Ces travaux permettent de montrer aux industriels l’intérêt de l’approche quantique, et en même temps de capitaliser des connaissances sur les algorithmes et les systèmes. »

Ces savoirs et ces compétences donneront une avance certaine aux chercheurs, lorsque le quantique arrivera… Quand ?

Pour qu’un ordinateur puisse exécuter un programme, il est nécessaire de formuler des instructions dans une langue intelligible pour lui : une succession de 0 et de 1. Plusieurs couches de traitement de l’information sont nécessaires pour parvenir à ce langage machine, de même à l’inverse, pour que les informations reçues en retour soient accessibles à un utilisateur humain.

Pour chacun de ces niveaux, un interpréteur ou un compilateur est un programme chargé d’effectuer une traduction dans le langage requis. Cet empilement de niveaux de langages intermédiaires, bien connu en informatique classique, reste encore dans une large mesure à inventer et à perfectionner pour les besoins de l’ordinateur quantique.

En France, la conception et le développement de cette « pile quantique » sont au cœur du projet EPiQ, développé dans le cadre du Plan quantique. « Il s’agit de réunir les chercheurs aguerris dans le domaine de l’informatique quantique, et qui peuvent apporter une expertise propre à chacune des couches de cette pile quantique », explique Alain Giorgetti, enseignant-chercheur en informatique à l’UMLP / Institut FEMTO-ST. Investi dans des aspects de « vérification », le chercheur apporte la preuve de bonnes propriétés d’un programme, par la démonstration mathématique, elle-même assistée par ordinateur (classique). L’adaptation de ces techniques de preuve aux programmes quantiques fait partie de la couche supérieure de la pile quantique.

Alain Giorgetti souligne l’intérêt du projet : « L’ordinateur quantique n’atteint pas encore les performances voulues, car il ne dispose pour l’instant que de quelques qubits, et produit des erreurs parce qu’il fonctionne dans un environnement bruité. Mais créer la pile quantique permet de prendre de l’avance, et de se tenir prêt pour accompagner ses futurs développements. »